[프로젝트] 교통 표지판 이미지 분류

프로젝트 목표

- 교통 표지판 이미지 데이터를 분석하고 딥러딩 모델을 통하여 표지판 종류를 예측하는 분류 모델 수행

- 대량의 이미지 데이터를 전 처리하는 과정과 이에 따른 CNN 모델의 성능 변화를 학습

프로젝트 목차

- 데이터 분석: 이미지 데이터를 이루고 있는 요소에 대해서 Dataframe를 사용하여 분석 및 확인

1-1. 이미지 데이터 정보 파악하기 - Meta

1-2. 이미지 데이터 정보 파악하기 - Train

1-3. 이미지 데이터 정보 파악하기 - Test

- 데이터 전 처리: 이미지 데이터를 읽어오고 딥러닝 모델의 입력으로 전 처리

2-1. 이미지 데이터 읽기

2-2. label 데이터 읽기

2-3. 데이터 분리하기

- 딥러닝 모델: CNN 모델을 구현하고 학습, 평가 및 예측을 수행

3-1. CNN 모델 설정

3-2. 학습 수행

3-3. 모델 성능 평가 및 예측

데이터 출처

https://www.kaggle.com/meowmeowmeowmeowmeow/gtsrb-german-traffic-sign

https://2021nipa.elice.io/explore

프로젝트 개요

차량 운전을 하면서 도로 교통 표지판을 보고 규칙을 지키는 것은 운전자의 및 교통 안전을 위해서 중요한 일입니다. 만일 사람이 아닌 기계가 이를 수행해야 한다면, 어떻게 표지판을 구분할 수 있을까요? 이러한 물음은 자율 주행차 기술이 발전하면서 중요한 이슈가 되었고, 딥러닝 기술 바탕의 분류 모델이 상당한 수준의 정확도를 보이며 적용되고 있습니다.

이번 프로젝트에서는 교통 표지판 분류의 첫 번째 스텝으로 간단하게 교통 표지판 이미지가 입력 되었을 때 이 것이 43 종의 표지판 중 어떤 것인가를 분류하는 딥러닝 모델을 구현합니다. 이를 통하여 교통 표지판 이미지 데이터들의 특징과 CNN 모델을 통하여 분류를 수행하는 것을 학습할 수 있습니다.

첫 번째 스텝을 확장하여, 추 후에는 교통 표지판만 있는 이미지를 입력으로 하지 않고 도로 이미지에서 교통 표지판을 분리하여 분류하는 Object detection 모델을 사용할 것이며, 최종적으로는 센서로 입력받는 비디오 이미지에서의 교통 표지판을 분리하고 분류하는 모델을 수행할 수 있습니다.

import os

import pathlib

import numpy as np

import matplotlib.pyplot as plt

from tqdm import tqdm

from sklearn.model_selection import train_test_split

from tensorflow.keras.preprocessing import image

from tensorflow.keras.preprocessing.image import ImageDataGenerator, img_to_array, array_to_img, load_img

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.layers import Conv2D, MaxPool2D, Dense, Flatten, Dropout

from tensorflow.keras.models import Sequential

%matplotlib inline1. 데이터 분석

1-1. 이미지 데이터 정보 파악하기 - Meta

file_list = os.listdir('./data')

file_list

Meta_images = []

Meta_labels = []

plt.figure(figsize=(16,16))

for i in range(len(df_Meta)):

img = load_img('./data/'+df_Meta['Path'][i])

plt.subplot(1, 3, i+1)

plt.imshow(img)

Meta_images.append(img)

Meta_labels.append(df_Meta['ClassId'][i])

1-2. 이미지 데이터 정보 파악하기 - Train

df_Train = pd.read_csv('./data/Train.csv')

df_Train

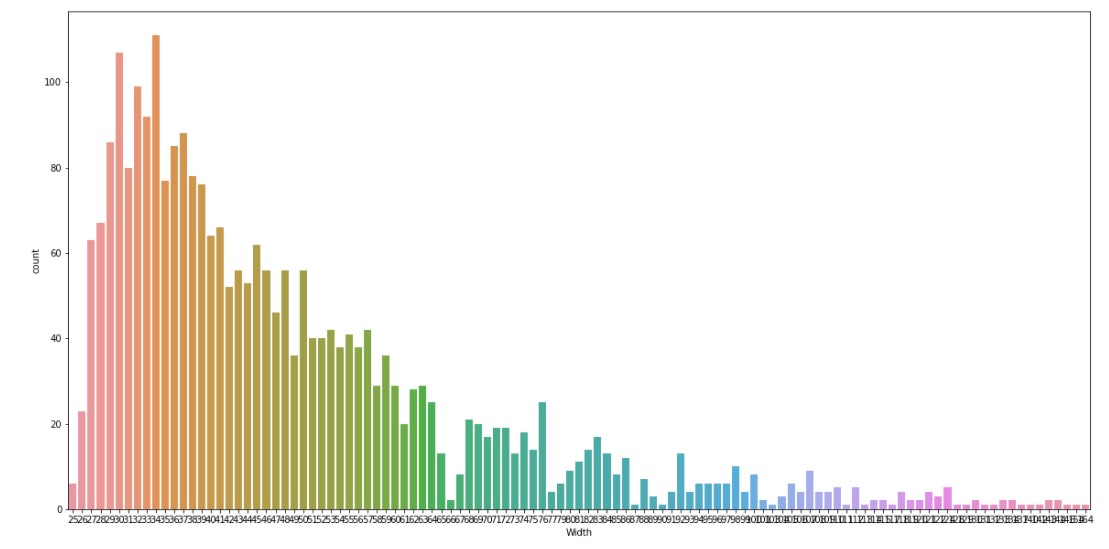

Width와 Height 정보는 이미지의 폭과 높이에 대한 정보로 간단히 샘플만 봐도 다양한 크기를 갖는 것을 알 수 있습니다. 이미지 크기가 모두 다르다면 이미지마다 서로 다른 feature의 개수가 있는 것이기에 이를 통일해주는 전 처리가 필요합니다. 그렇다면 어떤 크기로 통일을 해야 할까요? 이미지 크기의 분포를 보고 판단해봅시다.

import seaborn as sns

plt.figure(figsize=(20,10))

ax = sns.countplot(x="Width", data=df_Train)

df_cutWidth = pd.cut(df_Train['Width'], np.arange(0,200,10)).value_counts(sort=False)

fig, ax = plt.subplots(figsize=(20,10))

ax.bar(range(len(df_cutWidth)),df_cutWidth.values)

ax.set_xticks(range(len(df_cutWidth)))

ax.set_xticklabels(df_cutWidth.index)

fig.show()

* 30~35의 폭 또는 높이를 갖는 이미지가 제일 많음을 확인했습니다. 이미지 크기를 통일하는 데 있어서 너무 작은 이미지는 큰 이미지의 정보 손실을 발생하며, 너무 큰 이미지는 작은 이미지의 정보 부족한 정보량을 부각할 것입니다. 따라서 적절한 이미지 크기를 잡는 것은 하나의 파라미터 조정이 되며, 이번 프로젝트에서는 이미지 분포 기반으로 대다수를 차지하는 크기인 33x33 크기로 통일하겠습니다. (이후, 개인적인 실습에서 데이터 크기 조절에 따른 성능 변화를 살펴보는 것도 좋은 학습이 될 것입니다.)

image_height = 33

image_width = 33

image_channel = 3 # 컬러 이미지이기에 3채널

from PIL import Image

from PIL import ImageDraw

img_sample = Image.open('./data/'+df_Train['Path'][0])

draw = ImageDraw.Draw(img_sample)

draw.rectangle([df_Train['Roi.X1'][0], df_Train['Roi.Y1'][0], df_Train['Roi.X2'][0], df_Train['Roi.Y2'][0]], outline="red")

img_sample_resized = img_sample.resize((300,300))

img_sample_resized

* Roi 데이터를 사용하면 보다 명확하게 표지판 부분만을 crop 할 수 있으며, 이러한 데이터 전 처리를 통하여 분류의 성능을 높일 수 있습니다. (이번 프로젝트에서는 해당 전 처리를 생략합니다.)

img_sample_crop = img_sample.crop((df_Train['Roi.X1'][0], df_Train['Roi.Y1'][0], df_Train['Roi.X2'][0], df_Train['Roi.Y2'][0]))

# Shows the image in image viewer

img_sample_crop_resized = img_sample_crop.resize((300,300))

img_sample_crop_resized

1-3. 이미지 데이터 정보 파악하기 - Test

df_Test = pd.read_csv('./data/Test.csv')

df_Test

Train.csv와 같은 형태로 구성되어 있는 것을 알 수 있습니다. test 데이터에 대해서는 분석하는 것은 표지판을 분류 하는 목적에 있어 큰 의미가 있지 않기에 이번 실습에서는 생략합니다.

퀴즈1. Roi 영역에 크기에 맞게 df_Test['Path'][0] 해당되는 이미지에 crop을 수행한 후 (300, 300) 해상도로 resize 합니다.

# crop함수를 활용하여 이미지를 잘라낼 수 있습니다.

# 이 후, resize함수를 활용하여 사이즈 변경을 수행합니다.

img_sample_test = Image.open('./data/'+df_Train['Path'][0])

img_sample_crop_test = img_sample_test.crop((df_Train['Roi.X1'][0], df_Train['Roi.Y1'][0], df_Train['Roi.X2'][0], df_Train['Roi.Y2'][0]))

# Shows the image in image viewer

img_sample_crop_resized = img_sample_crop.resize((300,300))

img_sample_crop_resized

2. 데이터 전 처리

2-1. 이미지 데이터 읽기

image_height = 33

image_width = 33

image_channel = 3

Train_images = []

Train_labels = []

for i in tqdm(range(len(df_Train))):

img = load_img('./data/'+df_Train['Path'][i], target_size = (image_height, image_width))

img = img_to_array(img)

Train_images.append(img)

Test_images = []

Test_labels = []

for i in tqdm(range(len(df_Test))):

img = load_img('./data/'+df_Test['Path'][i], target_size = (image_height, image_width))

img = img_to_array(img)

Test_images.append(img)2-2. label 데이터 읽기

Train_labels = df_Train['ClassId'].values

Train_labels #array([0, 0, 0, ..., 2, 2, 2])

Test_labels = df_Test['ClassId'].values

Test_labels

'''

array([1, 1, 2, 2, 1, 1, 2, 1, 1, 1, 1, 2, 1, 2, 2, 1, 2, 1, 2, 1, 2, 2,

1, 0, 0, 1, 2, 1, 1, 1, 1, 1, 2, 1, 1, 2, 2, 2, 2, 1, 1, 2, 1, 0,

2, 2, 2, 1, 2, 1, 2, 1, 2, 2, 1, 2, 1, 1, 1, 1, 1, 1, 2, 0, 1, 2,

'''2-3. 데이터 분리하기

x_train, x_val, y_train, y_val = train_test_split(np.array(Train_images), np.array(Train_labels), test_size=0.4)

x_test = np.array(Test_images)

y_test = np.array(Test_labels)

3. 딥러닝 모델

3-1. CNN 모델 설정

CNN을 사용하여 간단하게 모델을 구현해 보겠습니다. filters, kernel 등의 사이즈는 하이퍼 파리미터로 자신만의 모델로 튜닝이 가능합니다.

model = Sequential([

Conv2D(filters=32, kernel_size=(3,3), activation='relu', input_shape=(image_height, image_width, image_channel)),

MaxPool2D(pool_size=(2, 2)),

Dropout(rate=0.25),

Conv2D(filters=64, kernel_size=(3,3), activation='relu'),

MaxPool2D(pool_size=(2, 2)),

Dropout(rate=0.25),

Flatten(),

Dense(512, activation='relu'),

Dropout(rate=0.25),

Dense(3, activation='softmax')

])

model.summary()

3-2. 학습 수행

model.compile(

loss='sparse_categorical_crossentropy',

optimizer='adam',

metrics=['accuracy']

)

# 처음 만든 모델이라면 EPOCHS를 1~5개로 하여 잘 돌아가는지 성능을 확인해보고 값을 증가 시켜 봅시다.

EPOCHS = 30

# EPOCHS에 따른 성능을 보기 위하여 history 사용

history = model.fit(x_train,

y_train,

validation_data = (x_val, y_val), # validation 데이터 사용

epochs=EPOCHS,

)

'''

Epoch 30/30

51/51 [==============================] - 1s 28ms/step - loss: 0.4736 - accuracy: 0.7948 - val_loss: 0.3615 - val_accuracy: 0.8511

'''학습을 수행하면서 Accuracy와 Loss의 변화를 그래프로 출력하면 다음과 같습니다.

accuracy = history.history['accuracy']

val_accuracy = history.history['val_accuracy']

loss=history.history['loss']

val_loss=history.history['val_loss']

epochs_range = range(EPOCHS)

plt.figure(figsize=(16, 8))

plt.subplot(1, 2, 1)

plt.plot(epochs_range, accuracy, label='Training Accuracy')

plt.plot(epochs_range, val_accuracy, label='Validation Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.subplot(1, 2, 2)

plt.plot(epochs_range, loss, label='Training Loss')

plt.plot(epochs_range, val_loss, label='Validation Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()

3-3. 모델 성능 평가 및 예측

test_loss, test_accuracy = model.evaluate(x_test, y_test, verbose=0)

print('test set accuracy: ', test_accuracy)

#test set accuracy: 0.7814285755157471테스트 데이터를 입력하여 예측된 결과를 비교해 보겠습니다. 25개의 테스트 데이터를 불러와 실제 class와 예측 class를 출력하면 다음과 같습니다.

test_prediction = np.argmax(model.predict(x_test), axis=-1)

plt.figure(figsize = (13, 13))

start_index = 0

for i in range(25):

plt.subplot(5, 5, i + 1)

plt.grid(False)

plt.xticks([])

plt.yticks([])

prediction = test_prediction[start_index + i]

actual = y_test[start_index + i]

col = 'g'

if prediction != actual:

col = 'r'

plt.xlabel('Actual={} || Pred={}'.format(actual, prediction), color = col)

plt.imshow(array_to_img(x_test[start_index + i]))

plt.show()

confusion matrix를 시각화 하여 분류 학습 결과를 확인해봅니다.

import seaborn as sns

from sklearn.metrics import confusion_matrix

cm = confusion_matrix(y_test, test_prediction)

plt.figure(figsize = (20, 20))

sns.heatmap(cm, annot = True)

퀴즈2. 위 학습한 CNN 모델에서 학습용 데이터(x_train, y_train)의 confusion matrix를 구하세요.

# CNN 모델의 x_train에 대한 예측값을 구하고 confusion_matrix() 를 사용하면 confusion matrix를 구할 수 있습니다.

train_prediction = np.argmax(model.predict(x_train), axis=-1)

cm_train = confusion_matrix(y_train, train_prediction)

# confusion_matrix() 결과값을 저장합니다.

quiz_2 = cm_train

챌린지

이번 프로젝트에서 3개의 label에 대해서만 학습을 수행했지만, 원본 데이터에서는 43개의 label로 이루어져 있습니다. label 개수가 많아진 만큼 정확도를 높이기 위해서 전 처리 단계에서 crop 이미지를 사용하거나 Data augmentation을 통해서 상대적으로 적은 이미지 데이터의 수를 늘리는 방법 사용할 수 있습니다. 딥러닝 모델에서는 위 커스텀 CNN 모델 이외로 어느 정도 성능이 검증된 VGG, GoogLeNet, ResNet 등을 사용하여 성능을 높여보시길 바랍니다.

'개인공부 > Python' 카테고리의 다른 글

| 80. Python TextMining 연습문제(2) (0) | 2021.12.14 |

|---|---|

| 79. NIPA AI온라인 교육 AI 실무 응용 과정 (8)금융 거래 고객 신용 위험 예측 (0) | 2021.12.13 |

| 77. Python TextMining 연습문제(1) (0) | 2021.12.11 |

| 76. Python Cluster&Recommand 연습문제 (0) | 2021.12.10 |

| 75. NIPA AI온라인 교육 AI 실무 응용 과정 (6)의류 판매 상품 리뷰 분석을 통한 상품 추천 여부 예측 (0) | 2021.12.09 |